使用LMS部署本地离线Deepseek大模型

使用LMS部署本地离线Deepseek大模型

xukunLM Studio 介绍:

LM Studio是一款能够本地离线运行各类型大语言模型的客户端应用,通过LM Studio 可以快速搜索所需的llms类型的开源大语言模型,并进行运行。

通过使用LM Studio 在本地运行大语言模型可以更加快速的运行流畅的提问,并在独立的环境中保障数据不被监听和收集。

特点:本地、独立、离线

参考文档:docs

步骤:

首先进入官网Download下载页面,选择自己电脑的操作系统点击下载安装包

下载完成之后根据步骤安装好后双击进入

点击右上角的Skip onboarding跳过

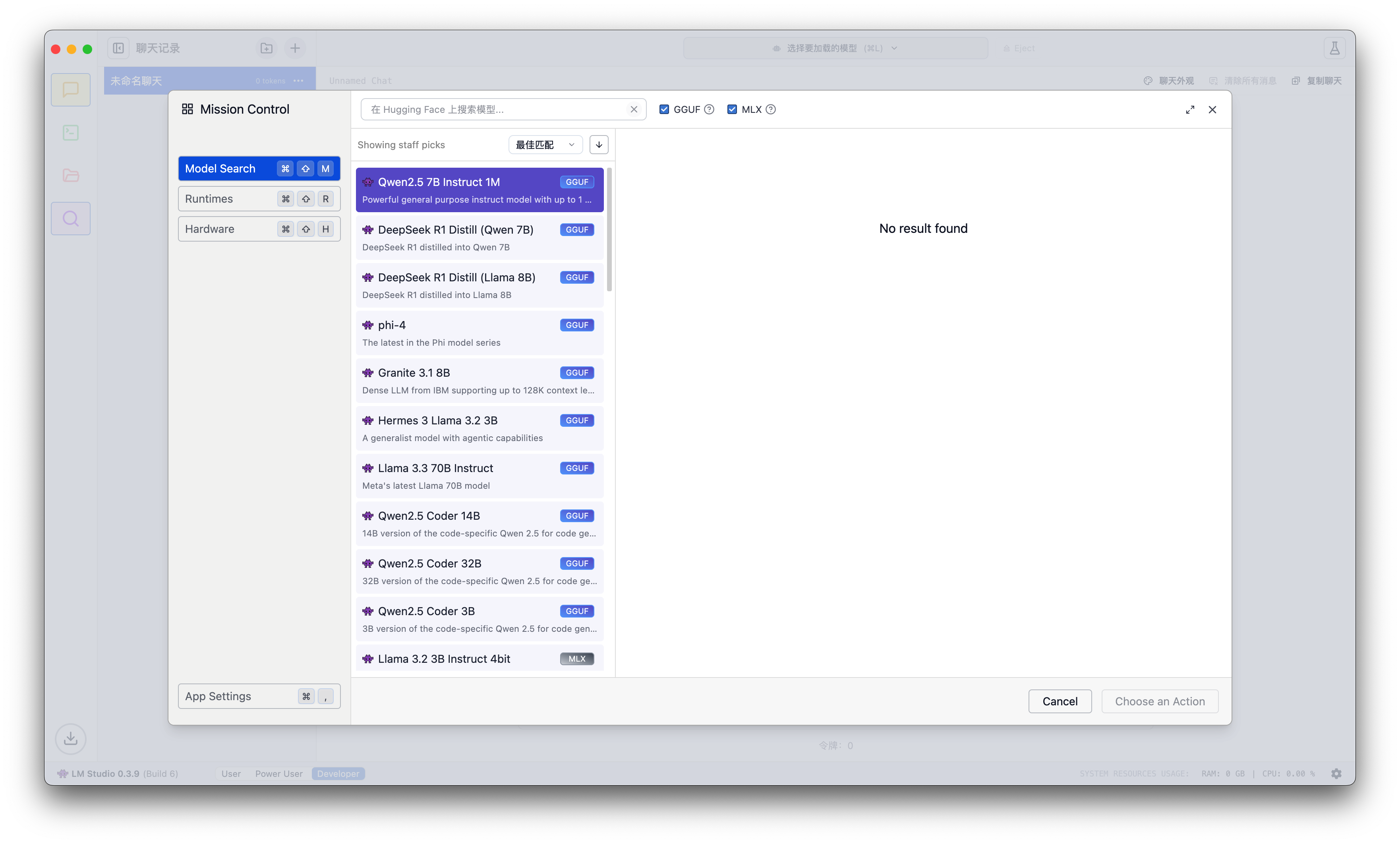

接着点击UI界面中间的“Select a model to load”,开始搜索模型,第一次搜索会显示No result found,列表可以看到,但无法进行下载模型。这个时候不要慌,因为https://huggingface.co/ 在国内是无法访问的

在软件内部获取模型的是通过https方式来访问的,全局代理也没有过去,因此科学上网也用不了

这时候只能用国内的同步的镜像: hf-mirror.com,用于替换镜像 huggingface.co 的域名,这样对应的模型就可以正常下载。

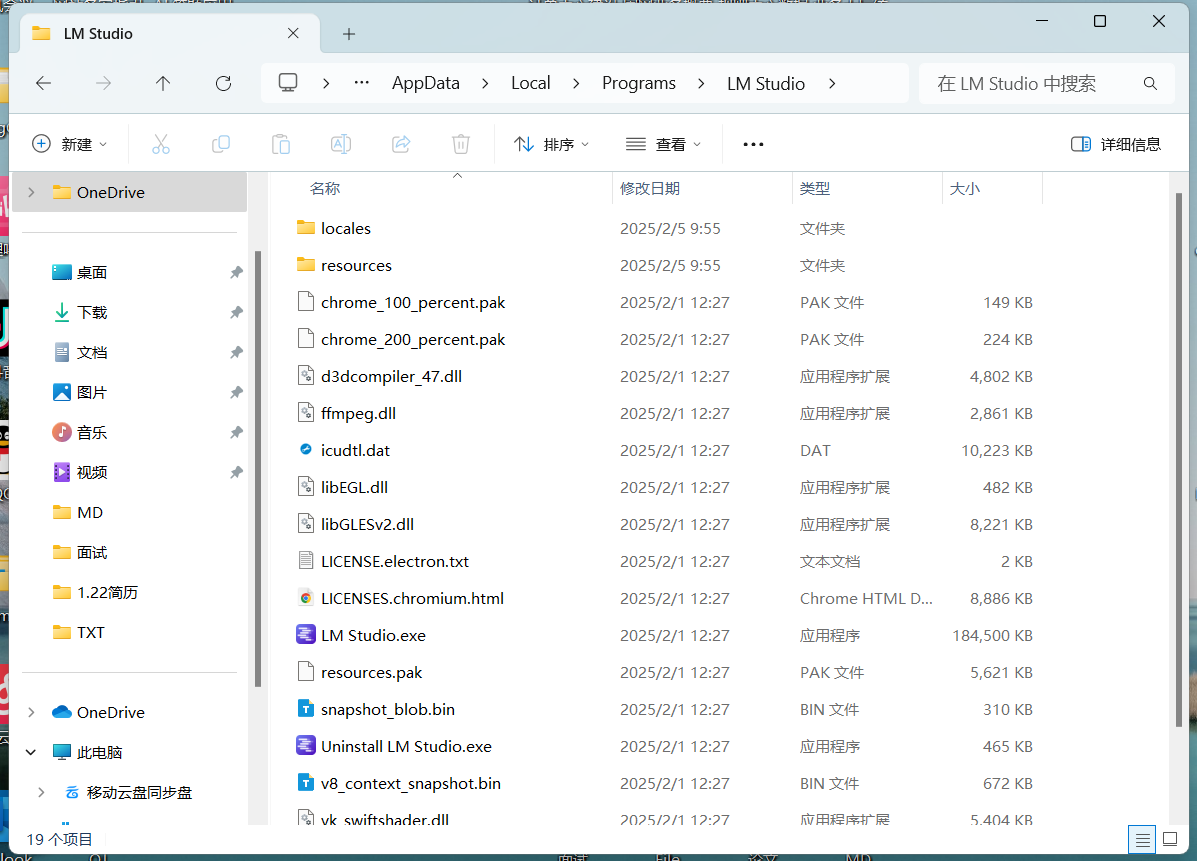

首先通过vscode或者其他编辑器,用vscode打开整个项目文件,全局替换 huggingface.co,将 LM Studio 程序中所有使用到 huggingface.co链接的地方都搜索出来,用 hf-mirror.com 替换,(替换完后保存并重启LLM)

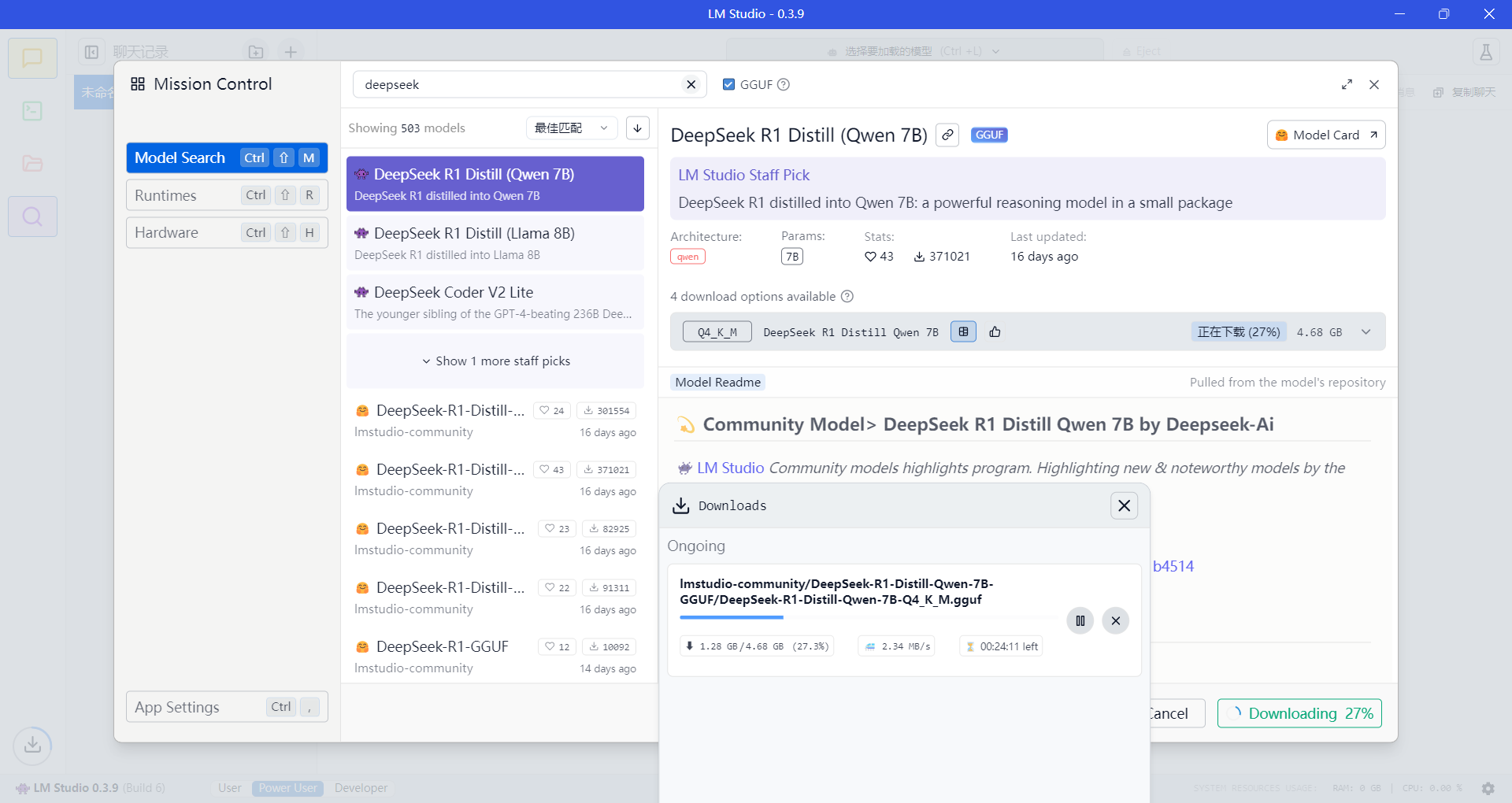

重新打开软件搜索模型,可以看到,已经能正常下载了

这里我们下载的是R1 Qwen 7b模型,模型的选择可以看自己的电脑配置

模型下载完后,根据指引直接进行加载并开启对话